#nvidia

NVIDIA planuje ograniczyć produkcję kart RTX 50 nawet o 40% na początku 2026 roku!

Według doniesień azjatyckich źródeł z łańcucha dostaw, NVIDIA może ograniczyć produkcję układów graficznych GeForce RTX z serii 50 w pierwszej połowie 2026 roku — podaje serwis Videocardz. Jak informuje Board Channels, całkowita podaż w pierwszym półroczu 2026 może być niższa o około 30–40% w...

Czy ktoś z szanownego grona ma notebooka z dedykowaną kartą graficzną #nvidia i używa na nim #linux (najlepiej jakiś debiano-podobny, bo wtedy mam przełożenie na Minta)?

Rozglądam się za nowym sprzętem i jednym z niewielu dostępnych bez licencji na Windows (a ta pójdzie prosto w kosz - starczy mi wrażeń na komputerze służbowym) jest ASUS TUF A16. No i ma to ustrojstwo procesor AMD Ryzen i kartę NVidia (z innych plusów ma aluminiową obudowę) - w jednych źródłach czytam, że potrafi to powodować problemy, inni twierdzą, że po prostu działa - ot, zainstalować własnościowe sterowniki NVidii tak jak Mint proponuje.

Ktoś? Coś?

@REXus Pisałem tutaj to parę razy już. Akurat ASUS ma community użytkowników linuxa i ci popisali parę skryptów i poradników które pomagają ogarnąć te laptopy. Sprawdź tutaj: https://asus-linux.org/

Z tym, że tam zalecane distro to jest chyba Arch, ewentualnie Fedora. Ale jak ci się nie chce bawić w Archa to każde distro bazujące na nim będzie też działać czyli np. EndeavourOS (którego gorąco polecam bo na nim siedzę od 3 lat) albo CachyOS.

Sam właśnie jestem przed kupnem lapka do Linuxa i myślałem nad którymś od ASUSa bo one powinny spoko działać z Linuxem. Na oku mam te 2: Asus TUF Gaming A14 albo ASUS ROG Zephyrus G14 (2025). Nie wiem w sumie ile jeszcze chce wydać na tego laptopa więc 2 z różnych półek cenowych.

@REXus Debian 13, świeżynka (wcześniej Pop, Elementary). Driver 590 Nvidii śmiga bez problemu. Choć tu uwaga - musiałem się nieco postarać, bo Debian stawia na stabilność i w standardowych repo nie ma nic ponad 550. To samo z CUDA (<12). Ale dało radę po chwili starań.

We wcześniejszych wszystko działało od strzała i po standardzie. Zresztą Pop'a dalej mam, jako drugi.

@REXus mam taki setup i problem na fedorze 43, po instalacji sterowników nvidia karta zaczęła chodzić na wayladzie na 3 % całe gui się zaczęło ścinać. Nie działało te całe dGPU iGPU tylko non stop nvidia musiałem wrócić do sterowników z kernela które obsługują tylko zintegrowaną w procku kartę AMD. Generalnie i tak mam gdzieś obsługę tej karty nvidia bo nie gram na lapku ale jak jest to chciałbym żeby działała.

Jak znajdziesz jakieś rozwiązanie to napisz mi tu albo na priv

Zaloguj się aby komentować

NVIDIA opracowała oprogramowanie pozwalające ustalić, w jakim kraju pracuje dany chip

Według informacji zdobytych przez Reuters – NVIDIA przygotowała funkcję, która ma umożliwić klientom ustalenie przybliżonego położenia geograficznego chipów AI wykorzystywanych w centrach danych. Oprogramowanie ma korzystać z zabezpieczonych mechanizmów przetwarzania oferowanych przez najnowsze GPU...

#nvidia RTX 5070 TI vs #amd RX 9070 XT

Co brać? Słucham Państwa. #pcmasterrace #gpu

Za Nvidią przemawia to, że obecnie mam 3070, a w drugim kompie mam 1060, z którymi nie miałem kompletnie żadnych problemów, podoba mi się ich apka i generalnie naturalnym krokiem wydaje się pójść dalej w nvidię, skoro mnie nie zawiodła.

Za AMD przemawia cena, bo Nvidia odleciała w tej kwestii. Windows też mnie już trochę denerwuje i zastanawiam się, czy nie przesiąść się na linuxa skrojonego pod gry, więc w takim przypadku lepiej byłoby mieć kartę od AMD... Ale ważna jest dla mnie też cisza i już czytałem kilka komentarzy o piszczących cewkach, czego już dawno temu doświadczyłem w dwóch kartach od AMD i jak miałbym do tego wracać, to chyba wolę Nvidie. No i Nvidia też wypina się coraz bardziej na graczy, więc nie chcę wspierać takiej firmy, swoim nic nie znaczącym zakupem, ale jednak zakupem.

Która karta?

- jako fanboi AMD powiem bierz AMD, nvidia leci w c⁎⁎ja z ceną - jako posiadacz linuksa, do niedawna nvidia to była katorga, ale ponoć już działa wszystko elegancko (odkąd otworzyli kod sterowników), więc raczej pod tym względem jeden uj (ale AMD dłużej ma fajną politykę xd fanboi się odezwał) - piszczenie cewek to podejrzewam że kwestia producenta karty a nie samych układów od AMD

Podsumowując:

Jeden uj (ale bierz AMD bo lepszy stosunek ceny do jakości xD)

"Nvidia fuck you" tak jak pan Linus powiedział.

NVIDIA to zamknięte sterowniki = problemy na linux.

AMD nie ma problemów z linux.

Tak, nvidia lepiej sobie radzi z RT, ale głównie w kilku żarłocznych grach, w większości nie ma istotnej różnicy.

DLSS lepsze od FSR, ale FSR 4 jest już całkiem fajne, to nie FSR 3 który był kaszaniasty. Ponadto nowsze wersje FSR 4 będą działać na 9070.

FSR 4 jest obecnie pomiędzy DLSS CNN a DLSS transformers. Jednak DLSS jest dostępny w naprawdę wielu grach, FSR niestety nie.

Jeśli windows, zależy od ceny, DLSS daje 30% wydajności, więc możesz podzielić cenę prez 0,7, ponieważ w FSR często nie jest dostępne. Więc raczej nvidia.

Jednak jeśli chcesz mieć furtkę do linux, zostaje jedynie AMD.

Zaloguj się aby komentować

Zaloguj się aby komentować

Ups, znów przewidywania nie wyszły.

Nvidia o reindetrualizacji no i Wojczal na dokładkę.

https://www.krzysztofwojczal.pl/nowy-wpis/nowy-amerykanski-porzadek-projekt-wielkiej-reindustrializacji-usa/

https://streamable.com/by2ba6

#usa #nvidia

Zaloguj się aby komentować

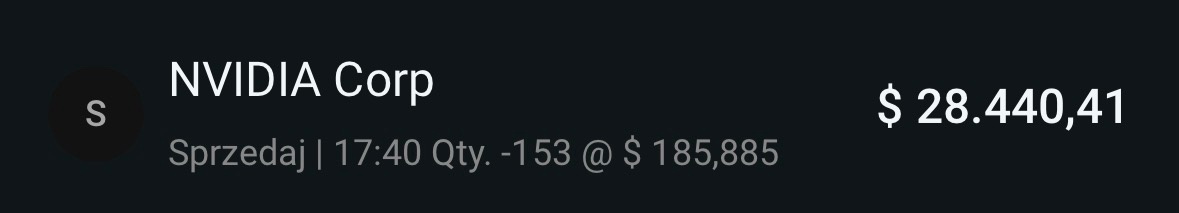

Nastala ta chwila. Spadnie to znowu kupie :)

#gielda #inwestycje #nvidia

@bartek555 w końcu zacząłem coś oszczędzać też muszę chyba dywersyfikować pieniądze.

Zapomnialem najwazniejsze tagu #bartektrejduje

@bartek555 wszystkie spółki, które obserwuje ostatnio - wymaksowane. Korekta wisi w powietrzu.

Zaloguj się aby komentować

Dawno nie wrzucałeś ile tych dularów już nachapałeś. Albo nie ma się czym chwalić hehe albo pieniądze lubią ciszę

Zaloguj się aby komentować

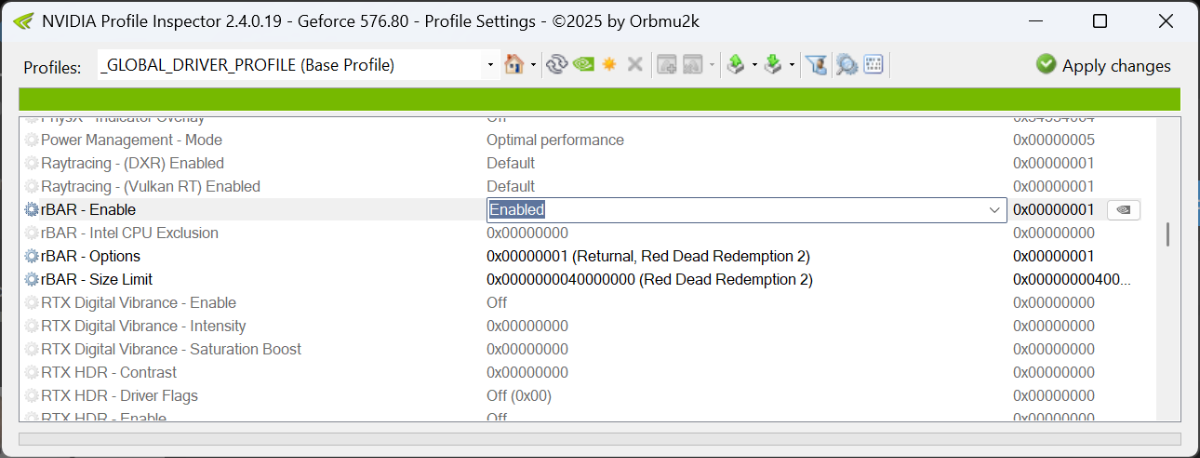

Sterowniki NVIDIA domyślnie mają wyłączony rBAR, ignorują ustawienia BIOS!

Jak donosi JayzTwoCents domyślnie sterowniki NVIDIA mają wyłączoną opcję rBAR na poziomie sterownika i ignorują włączoną opcję rBAR w BIOS/UEFI.

https://youtu.be/z-ggq_S3sDQ?t=156

rBAR

Resizable BAR (ang. Base-Address Register) to technika interfejsu PCI-Express. Stanowi ona część specyfikacji PCIe 3.0, ale dopiero od końca 2020 roku producenci sięgnęli po to rozwiązanie, by poprawić wydajność w grach. I NVIDIA wcale nie była pierwsza, choć to właśnie na Resizable BAR w wydaniu „zielonych” skupię się w tej publikacji.

Co robi Resizable Bar? Usprawnia komunikację między CPU a GPU, usuwając ciągnące się od lat ograniczenie z ery 32-bitowej....

I jak tam $tsla $nvda? Urus, zmalau? Koniec tesli?

#gielda #inwestycje #tesla #nvidia

Chyba nie. A tak z Ciekawości Ty inwestujesz długoterminowo czy tylko handelek żeby realizować szybko zyski?

@bartek555 Wąski, coś Ty się taki hardy zrobił?

Ile to ciszy było? ( ͡° ͜ʖ ͡°)

Spokojnie z tymi wzrostami

@bartek555 spokojnie, jeszcze ze trzydzieści razy coś Trump odpierdoli

Zaloguj się aby komentować

czy dokupilem nvidii za 5k? byc moze.

#bartektrejduje #nvidia #gielda

@bartek555 Też sobie z procesorów mozaike robię.

jak na moje oko to jeszcze sprawdzą ostatni dołek

Were you trading or gambling?

Zaloguj się aby komentować

Z Titanem Xp chyba lepiej wygląda ( ͡° ͜ʖ ͡°)

#pcmasterrace #nvidia #komputery #kartygraficzne #gpu

Zaloguj się aby komentować

Zboostowanie 1 litrowego PC zewnętrznym GPU.

#pcmasterrace #nvidia #intel #komputery #ciekawostki #kartygraficzne

@NrmvY tak to widze xD

@NrmvY nic nie przebije Velka 3

ja mam GPD Win Max, 8" laptopa-handhelda, ktorego podlaczam sobie do Aorus Boxa z AMD Fury Nano w srodku. Mniejsze i laptop moze dzialac niezaleznie, na baterii, ma wbudowany ekran i klawiature. Nigdy nie kumalem tych nettopow podlaczonych do egpu.

Zaloguj się aby komentować

Elo. Posiadam procek i5 4690 i mam do wyboru dwie karty: GTX 1060 3 gb i Radeon rx 470 4gb.

Która będzie lepsza do starszych gierek w dx11? Minusem czerwonych jest wysoki pobór mocy i temperatury,

zaś zieloni mają mniej vramu. Co sądzicie? Wiem, że to starocie, ale kompa będę zmieniał za rok, jak połatają STALKERA 2 xD #komputery

#pcmasterrace #nvidia #amd #kartygraficzne

Ja byl bral radeona bo ta generacja rx 470 byla na prawde spoko, temperatura / wieksze zuzucie energi na rok nie zmieni za duzo.

Ja mam wciąż tego radeona i potrawki pociągnąć wymagające gry np rdr2 minusem są piszczące cewki przy obciążeniu. Wydaje się też, że więcej vramu wygrywa tym bardziej, że teraz 4GB to bardzo mało

Zdefiniuj starsze gierki i w jakiej rozdzielczości planujesz grać. Jak do 2011 w 4k to bralbym GTX 1060. Od tego mniej więcej roku gry zżerają mi więcej niż 3gb vram.

Zaloguj się aby komentować

#amd #nvidia #kartygraficzne #takaprawda

Sprzedawcy trzymaja się cen MRSP bardzo mocno XD

@binarna_mlockarnia na MSRP to oni patrzą z góry ( ͡° ͜ʖ ͡°)

Zaloguj się aby komentować

Jeśli planowaliście kupno nowych kart graficznych od #nvidia to lepiej dobrze się zastanówcie co robicie. Media zaczynają donosić o sporej ilości problemów:

Użytkownicy kart graficznych GeForce RTX 50 nadal skarżą się na problemy ze stabilnością swoich GPU, w tym na czarne ekrany i awarie systemu, a NVIDIA wciąż nie ma gotowej poprawki.

Oprócz tego:

Premiera serii GeForce RTX 50 jest jedną z najbardziej problematycznych w historii firmy. Gracze i entuzjaści PC muszą zmagać się nie tylko z niedostępnością GPU i wysokimi cenami, ale również z problemem topiących się 16-pinowych złączy zasilania. Dodatkowo pojawiły się wady sprzętowe, np. przypadki kart z mniejszą liczbą jednostek ROP, niż deklarował producent. Do tego wszystkiego wydajność grafik z rodziny Blackwell po prostu rozczarowuje, więc nie rysuje to dobrego obrazu serii RTX 50.

Jeśli ktoś doczytał do tego miejsca to może się zacząć zastanawiać o co chodzi z mniejszą ilością ROP'ów. No to już odpowiadam:

Według licznych doniesień, niektóre modele tej serii mogą posiadać wadę produkcyjną, która prowadzi do scalania partycji ROP (Render Output Unit) w procesorze graficznym, co bezpośrednio wpływa na spadek wydajności urządzeń.

Użytkownik reddita przeprowadził testy swojego RTX 5080 w popularnym benchmarku 3DMark Time Spy. Wyniki okazały się niepokojące – karta osiągnęła wynik 28 118 punktów, podczas gdy sprawna jednostka uzyskuje aż 32 273 punktów. Różnica wynosząca 12% jest ogromna, szczególnie w kontekście urządzeń klasy premium.

https://ithardware.pl/aktualnosci/nvidia_problemy_bsod_rtx_50_poprawki-39245.html

https://ithardware.pl/aktualnosci/rtx_5080_rop_wydajnosc_wpadka_nvidia-39271.html

#gpu #kartygraficzne #technologia

Intel się już wy⁎⁎⁎ał. Teraz pora na nvidię

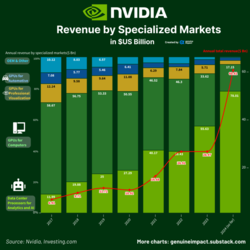

@PanNiepoprawny Karty graficzne dla konsumentów to teraz pewnie jakiś promil dochodów nvidii więc spokojnie, tak szybko się nie wyjebią.

@hellgihad A ja myślę że może jednak się wyjebią. Chińskie modele językowe pokazały że nadszedł czas optymalizacji AI, tak więc nowy hardware przez dłuższy czas nie będzie już tak pilnie potrzebny jak był przez ostatnie lata.

Najpierw Intel teraz NVIDIA... d

Doczekaliśmy czasów w których będziemy się cieszyć z bezawaryjnego produktu....

@damw Prawda jest generalnie oczywista, Nvidia ma totalnie w d⁎⁎ie tworzenie konsumenckich kart graficznych dla graczy czy pół profesjonalistów i całą uwagę skupia na akceleratorach AI. Dosłownie nie opłaca im się marnować zasobów ludzkich jak i wolnych przydziałów za zamówienia wafli krzemowych na gałąź biznesu która daje im tak małe przychody w porównaniu do AI. I tak będzie dopóki cała ta bańka nie walnie w końcu.

Ja tutaj tylko zostawię te 3 obrazki:

Zaloguj się aby komentować

Problemów z nową generacją Gefore'ów ciąg dalszy (kolejne opóźnienia):

Jak podaje chiński serwis CTEE, jednym z powodów opóźnienia premiery kart graficznych GeForce RTX 5070 i RTX 5060 są problemy z wydajnością tych modeli. Układy rzekomo nadal wymagają dalszego debugowania. Dodatkowo sytuacji wcale nie ułatwiło niedawne trzęsienie ziemi w Tainan. W rezultacie masowa produkcja została ponoć opóźniona aż o cztery tygodnie, przy czym RTX 5070 ma być dostępny w połowie marca, natomiast RTX 5060 dopiero w połowie kwietnia. Mówiąc krótko, wiele wskazuje na to, że konsumenci będą mieli spore problemy z zakupem tych układów w okolicach premiery

#technologia #kartygraficzne #geforce #nvidia

Tylko teraz są takie kwiatki czy może wcześniejsze generacje też robiły takie fikołki?

@Marchew nvidia od kilku generacji robi papierowe premiery. Na prezentacji gada o szerokiej dostępności i masowej produkcji, a potem czekasz pół roku aż się coś pojawi co można kupić w sklepie.

Moore's Law is dead ostatnio miał nawet filmik o rzekomej dostępności tych nowych GPU: https://www.youtube.com/watch?v=sTbGIiGvlIU - w skrócie: premiera jeszcze bardziej papierowa niż Ada Lovelace

Więc pozostaje poczekać pół roku, wyjdzie w sam raz na wakacyjne obniżki.

Jak ze wszystkim - nie kupuje się pierwszej wersji produkcyjnej tylko poliftową

@PanNiepoprawny a pomyśl, że nadal są osoby, co biorą w ciemno w przedsprzedaży...

@damw Premiera nowej generacji to zawsze dobra okazja na wymianę karty na coś ze starszej generacji xD

@hellgihad tylko jeśli nie jesteś jedną z tych osób, które zawsze muszą mieć najdroższe, najnowsze i najbardziej "lanserskie"

@damw Moje wymagania co do hardwaru kończą się na "nowe gry mają latać w 60FPS"

Zaloguj się aby komentować