Czy zauważyliście spadek jakości #chatgpt w ostatnim czasie?

Bo ja zdecydowany, ale nie wiem na ile to problem jednostkowy a na ile globalny. Nie używam go super często (darmowa subskrypcja z reguły wystarcza), zacząłem jakoś w ale kiedyś mam wrażenie działał lepiej, a od dwóch dni to w ogóle jakbym rozmawiał z zupełnie innym modelem, mimo że w historii wszystko ma zapamiętane!. Opiszę swoje przykłady bo ciężko mi to zebrać w skrócie:

"Konsultuję się" z gpt w sprawie scenariuszy i fabuł, które przygotowuję na sesje D&D. Początkowo dość szybko złapał mój styl gry, pamiętał postacie, ich przygody, odwiedzone lokacje, jakieś większe koncepcje świata różniące się od tych z podręczników - i potrafił elegancko podpowiedzieć gdzie jakiego potwora można spotkać, jaka pułapka-zagadka byłaby dobra do rozwiązania przez konkretnego członka drużyny, wymyślić jakiś artefakt, zasugerować zaklęcie (i nawet podać podręcznik i stronę XD).

W poniedziałek poprosiłem go o to samo i wypluł mi jakąś generyczną odpowiedź, gdzie rzucał losowymi wymyślonymi nazwami, nie skojarzył wcale poprzednich gier ani "na czym skończyliśmy" chociaż wcześniej ogarniał to perfekcyjnie, sam wymyślał zaklęcia a logiki w jego uzupełnieniu do scenariusza nie można się było doszukać żadnej.

Czasem pytam czat o jakieś szczegóły związane z grą/serialem. Mówię w którym momencie fabuły jestem i proszę żeby nie spojlerował. I zawsze elegancko dostawałem odpowiedź bez spojlerów.

A dziś poprosiłem o wyjaśnienie jednej kwestii w grze, bez spojlerów bo jestem jeszcze na początkowym etapie, a nie wiem czy coś przeoczyłem czy później się tego dowiem - pytanie na które odpowiadasz tak albo nie. To mi jebaniutki opisał całe zakończenie wątku fabularnego zanim odpowiedział XD

No i w sumie temat do którego używam go najczęściej, prawie codziennie od października: bajki o "policyjnym tramwaju" XD Dzieciak poprosił o taką przed snem, opowiedziałem mu, spodobała się i chciał jeszcze - wtedy posiliłem się czatem, bo temat dość abstrakcyjny a miałem pustkę w głowie. I po kilku promptach doprecyzowujących miałem całe spójne uniwersum (na standardy bajek dla 3latków) XD Czasem podaję konkretnie o czym ma być następna historyjka, ale najczęściej piszę tylko "jeszcze" i ten ogarnia całą 'oryginalną' fabułę. Zawsze korzystam z tego samego czata, tj. wybieram w historii i mam wgląd na wszystkie poprzednie historyjki.

Od kilku dni bajki się powtarzają, albo zmienia w nich pojedyncze postacie i miejsca, a fabuła i dialogi są te same XD Jak proszę o poprawienie, to generuje jakąś bajkę którą już opowiadał, ale innymi słowami. Przedwczoraj to w ogóle po pierwszym prompcie od ponad 48h (bo tyle go nie używałem) wysypał error, nie odpowiedział i oznajmił że skończył mi się plan i żebym korzystał dalej to muszę wykupić (nie mogłem nawet korzystać z tej biedniejszej wersji modelu, jak to było kiedyś). A wczoraj jak poprosiłem o bajkę, to odpisał żebym podał mu tytuł o czym ma być XD Jak kazałem wymyślić mu samemu, to "wymyślił" ostatnią bajkę jaką mi wygenerował, po zwróceniu uwagi wymyślił nową, ale całkowicie pozmieniał imiona bohaterów a samą bajkę generować musiałem na 3 zapytania. Bo w samym środku akcji bajka kończyła się "Czy uda im się rozwiązać ten problem?" XD I co lepsze, jak prosiłem o kontynuację, to przepisywał ostatni akapit z poprzedniej odpowiedzi, ale go trochę zmieniał, w tym fabularnie.

A jak spytałem kiedy opowiedział mi pierwszą bajkę z tej serii, to dostałem odpowiedź, że nigdy mi takiej nie opowiadał XD

No generalnie czat mi ostatnio strasznie halucynuje i odstawia cyrki na kółkach, trochę słaba reklama w momencie jak już zacząłem bardzo poważnie rozważać przejście na premium XD

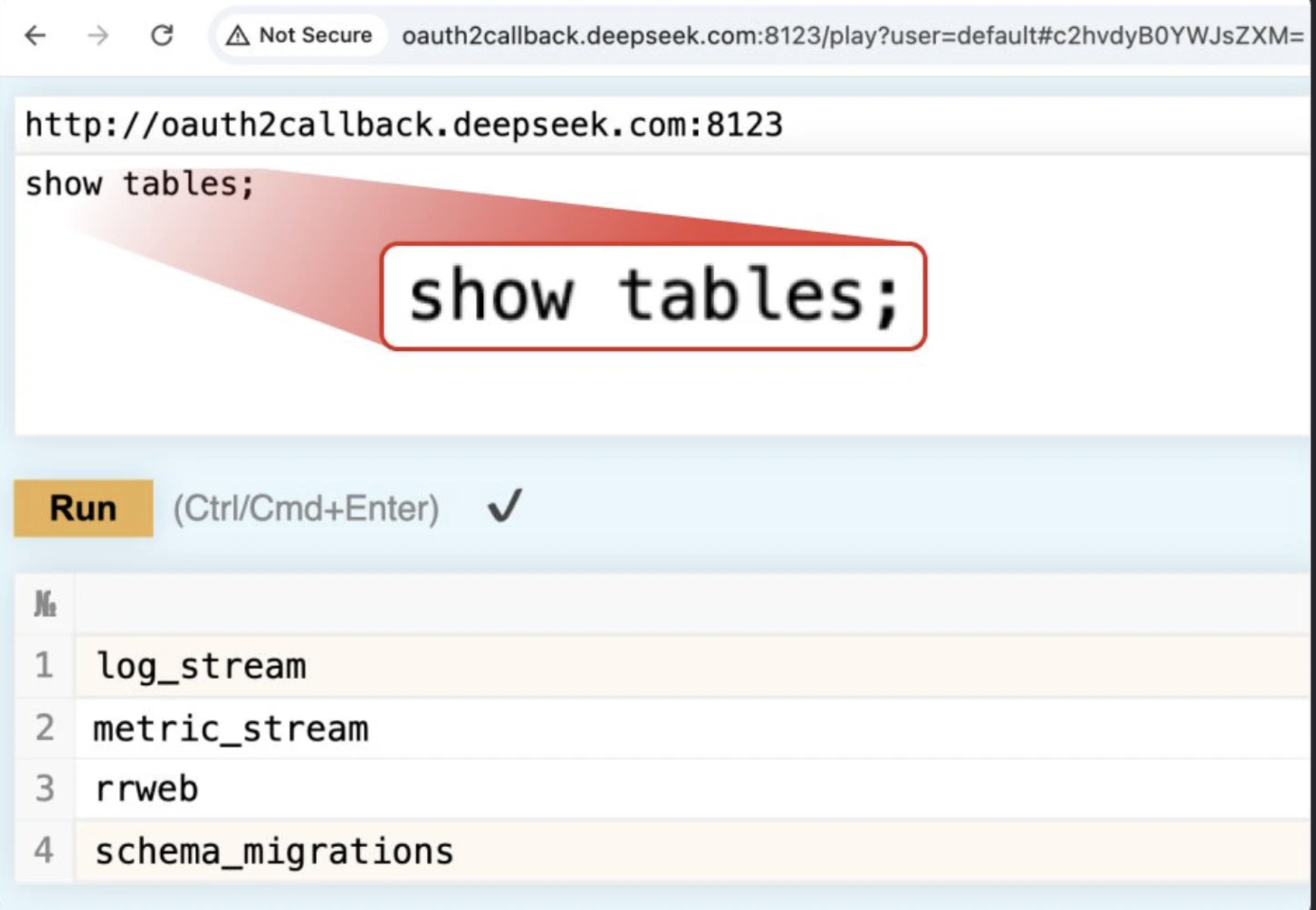

Ktoś też ma podobne problemy? Co może być alternatywą, deepseek legit czy scam?